Faça uma pergunta em ChatGPT, Perplexity, Gemini ou Copilot, e a resposta aparece em segundos. Parece fácil. Mas sob o capô, não há mágica. Há uma luta acontecendo.

Esta é a parte do oleoduto em que seu conteúdo está em uma luta de facas com todos os outros candidatos. Cada passagem no índice deseja ser a que o modelo seleciona.

Para os SEOs, este é um novo campo de batalha. O SEO tradicional era sobre a classificação em uma página de resultados. Agora, o concurso acontece dentro de um sistema de seleção de respostas. E se você deseja visibilidade, precisa entender como esse sistema funciona.

Crédito da imagem: Duane Forrester

Crédito da imagem: Duane ForresterO estágio de seleção de respostas

Isso não é rastejando, indexando ou incorporando em um banco de dados vetorial. Essa parte é feita antes que a consulta aconteça. A seleção de respostas entra em ação depois que um usuário faz uma pergunta. O sistema já possui um conteúdo, incorporado e armazenado. O que ele precisa fazer é encontrar passagens candidatas, pontuá -las e decidir quais passarem para o modelo para a geração.

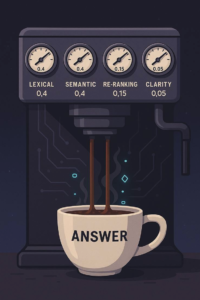

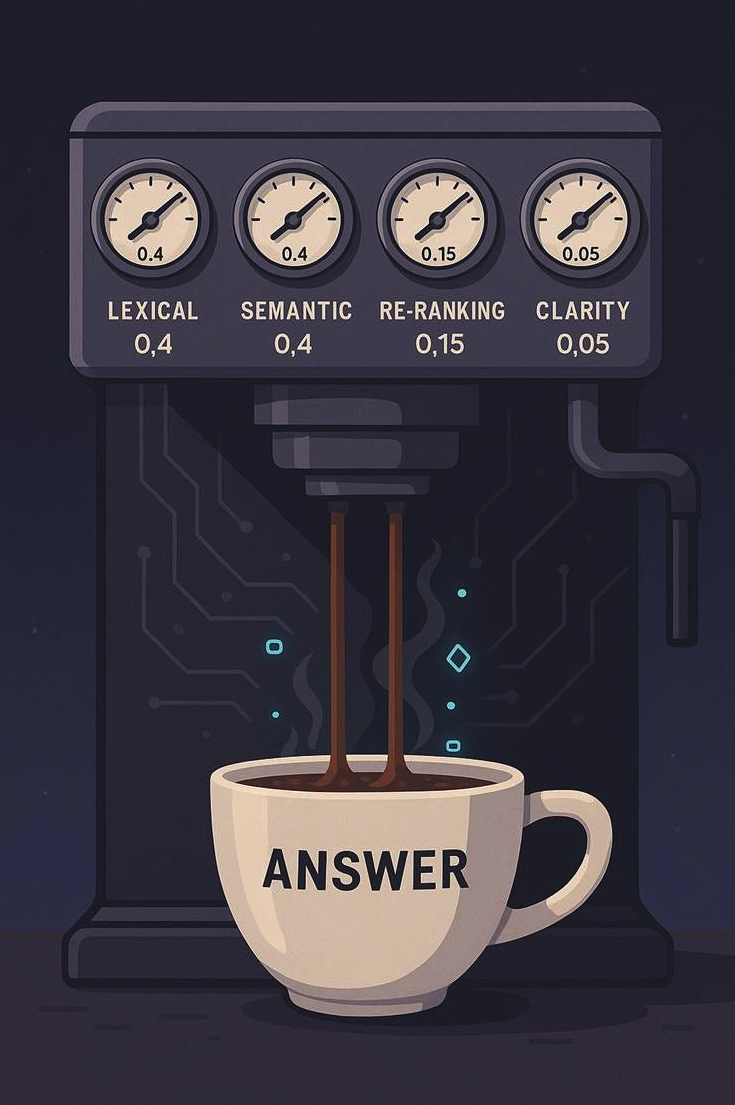

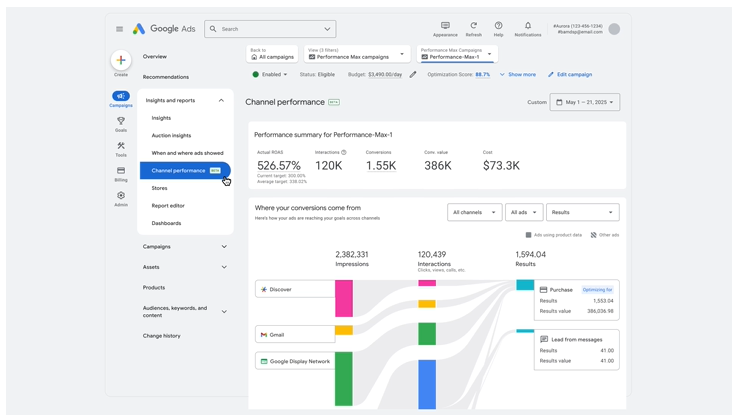

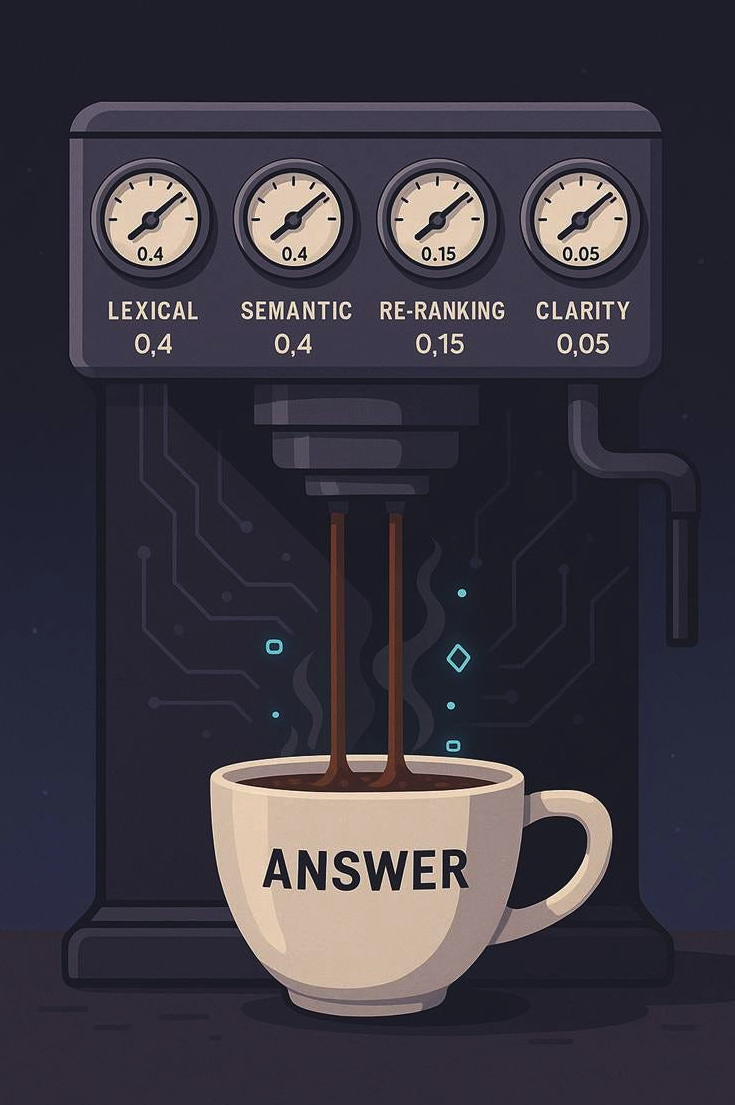

Todo pipeline de pesquisa de IA moderno usa os mesmos três estágios (em quatro etapas): recuperação, re-ranking e verificações de clareza. Cada estágio é importante. Cada um carrega peso. E enquanto todas as plataformas têm sua própria receita (a ponderação atribuída em cada etapa/estágio), a pesquisa nos oferece visibilidade suficiente para esboçar um ponto de partida realista. Basicamente, construir nosso próprio modelo para pelo menos replicar parcialmente o que está acontecendo.

A linha de base do construtor

Se você estivesse construindo seu próprio sistema de pesquisa baseado em LLM, teria que dizer quanto cada estágio conta. Isso significa atribuir pesos normalizados que somam um.

Uma pilha inicial defensável e informada pela pesquisa pode ficar assim:

- Recuperação lexical (palavras -chave, BM25): 0.4.

- Recuperação semântica (incorporação, significado): 0.4.

- Re-ranking (pontuação cruzada): 0,15.

- Clareza e impulsos estruturais: 0,05.

Todo sistema de IA importante tem sua própria mistura proprietária, mas todos estão se formando com os mesmos ingredientes do núcleo. O que estou mostrando aqui é o ponto de partida média para um sistema de pesquisa corporativo, não exatamente com o que ChatGPT, Perplexity, Claude, Copilot ou Gêmeos operam. Nunca conheceremos esses pesos.

Os inadimplência híbrida em toda a indústria fazem backup isso. Tecelaviate’s parâmetro alfa de pesquisa híbrida Padrão para 0,5, um equilíbrio igual entre a correspondência de palavras -chave e as incorporações. Pinecone ensina o mesmo padrão em sua visão geral híbrida.

A renomação recebe 0,15 porque se aplica apenas à lista curta. No entanto, seu impacto é comprovado: “A passagem de passagem com Bert” mostrou grandes ganhos de precisão quando Bert foi colocado em camadas na recuperação do BM25.

A clareza recebe 0,05. É pequeno, mas real. Uma passagem que lidera com a resposta é densa com fatos e pode ser levantada inteira, é mais provável que vença. Que corresponde às descobertas da minha própria peça sobreposição semântica vs. densidade.

À primeira vista, isso pode parecer “apenas SEO com matemática diferente”. Não é. O SEO tradicional sempre foi adivinhação dentro de uma caixa preta. Nós realmente nunca tivemos acesso aos algoritmos em um formato próximo às suas versões de produção. Com os sistemas LLM, finalmente temos algo pesquisa nunca nos deu: acesso a toda a pesquisa em que eles são construídos. Os densos trabalhos de recuperação, os métodos de fusão híbrida, os modelos de renomeamento, são todos públicos. Isso não significa que sabemos exatamente como o Chatgpt ou Gemini disca seus botões ou sintoniza seus pesos, mas isso significa que podemos esboçar um modelo de como eles provavelmente funcionam com muito mais facilidade.

De pesos à visibilidade

Então, o que isso significa se você não está construindo a máquina, mas competindo dentro dela?

A sobreposição leva você à sala, a densidade o torna credível, lexical o impede de ser filtrado e a clareza o torna o vencedor.

Essa é a lógica da pilha de seleção de respostas.

Recuperação lexical ainda é 40% da luta. Se o seu conteúdo não contiver as palavras que as pessoas realmente usam, você nem entra no pool.

Recuperação semântica é mais 40%. É aqui que as incorporações capturam significado. Um parágrafo que une conceitos relacionados mapas melhor do que aquele que é fino e isolado. É assim que seu conteúdo é escolhido quando os usuários frase as consultas de maneiras que você não previa.

Renomear é 15%. É onde mais clareza e estrutura são mais importantes. Passagens que parecem respostas diretas aumentam. Passagens que enterram a conclusão caem.

Clareza e estrutura são o desempate. 5% podem não parecer muito, mas em brigas próximas, decide quem vence.

Dois exemplos

O conteúdo de ajuda de Zapier

A documentação de Zapier é famosamente limpa e a resposta. Uma consulta como “Como conectar folhas do Google ao Slack”Retorna uma resposta ChatGPT que começa com as etapas exatas descritas porque o conteúdo da Zapier fornece os dados exatos necessários. Quando você clica em um link de recurso ChatGPT, a página em que você pousa não é uma postagem no blog; provavelmente não é um artigo de ajuda. É a página real que permite que você realize a tarefa que você solicitou.

- Lexical? Forte. As palavras “Google Sheets” e “Slack” estão ali.

- Semântico? Forte. Os clusters de passagem relacionados, como “integração”, “fluxo de trabalho” e “gatilho”.

- Reannando? Forte. As etapas lideram com a resposta.

- Clareza? Muito forte. Formatação digitalizável e de resposta.

Em um sistema 0,4 / 0,4 / 0,15 / 0,05, o ponto de partida de Zapier em todos os mostradores. É por isso que o conteúdo deles geralmente aparece nas respostas da IA.

Uma postagem de blog de marketing

Compare isso com uma postagem típica de blog de marketing longa sobre “hacks de produtividade da equipe”. O post menciona folga, folhas do Google e integrações, mas somente após 700 palavras de história.

- Lexical? Presente, mas enterrado.

- Semântico? Decente, mas espalhado.

- Reannando? Fraco. A resposta para “Como faço para conectar as folhas ao Slack?” está escondido em um parágrafo no meio do caminho.

- Clareza? Fraco. Nenhuma resposta elevável em primeiro lugar.

Embora o conteúdo tenha cubra tecnicamente o tópico, ele luta nesse modelo de ponderação. A passagem Zapier vence porque se alinha com a maneira como a camada de seleção de respostas realmente funciona.

A pesquisa tradicional ainda orienta o usuário a ler, avaliar e decidir se a página que ele aterrissa atende sua necessidade. As respostas da AI são diferentes. Eles não pedem que você analise os resultados. Eles mapeiam sua intenção diretamente para a tarefa ou respondem e o movem diretamente para o modo “Get It It”. Você pergunta: “Como conectar folhas do Google ao Slack,”E você acaba com uma lista de etapas ou um link para a página em que o trabalho é concluído. Você realmente não recebe um post explicando como alguém fez isso durante o intervalo do almoço e levou apenas cinco minutos.

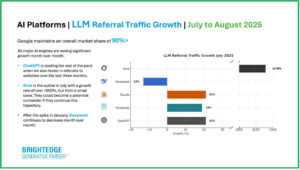

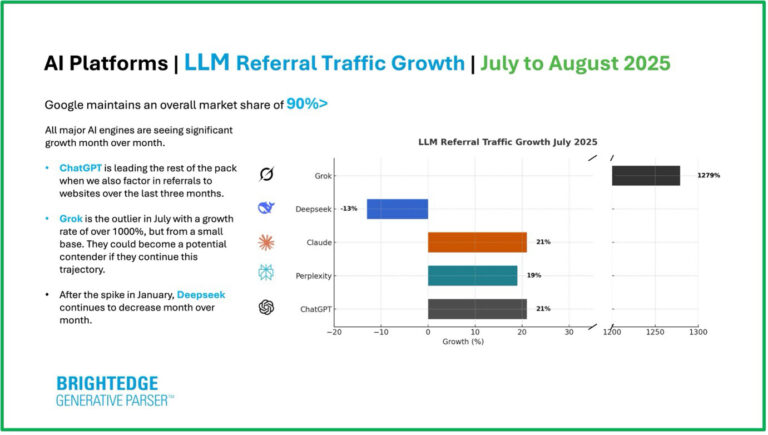

Volatilidade entre plataformas

Há outra grande diferença do SEO tradicional. Os mecanismos de pesquisa, apesar das mudanças no algoritmo, convergiram ao longo do tempo. Faça o Google e o Bing a mesma pergunta, e você verá resultados semelhantes.

As plataformas LLM não convergem, ou pelo menos, não estão tão longe. Faça a mesma pergunta em perplexidade, Gêmeos e Chatgpt, e você geralmente receberá três respostas diferentes. Essa volatilidade reflete como cada sistema pesa seus mostradores. Gêmeos pode enfatizar citações. A perplexidade pode recompensar a amplitude da recuperação. O ChatGPT pode comprimir de forma agressiva para o estilo de conversação. E temos dados que mostram que, entre um mecanismo tradicional e uma plataforma de resposta a LLM, há um amplo abismo entre as respostas. Dados do BrightEdge (62% de desacordo nas recomendações da marca) e Dados do profundo (… Os módulos e os mecanismos de resposta da IA diferem dramaticamente dos mecanismos de pesquisa, com apenas 8 a 12% de sobreposição nos resultados) mostre isso claramente.

Para os SEOs, isso significa que a otimização não é mais um tamanho único. Seu conteúdo pode ter um bom desempenho em um sistema e mal em outro. Essa fragmentação é nova e você precisará encontrar maneiras de resolvê -lo como comportamento do consumidor em torno do uso dessas plataformas para obter mudanças de respostas.

Por que isso importa

No modelo antigo, centenas de fatores de classificação borraram juntos em um “melhor esforço” de consenso. No novo modelo, é como se você estivesse lidando com quatro grandes mostradores, e toda plataforma os sintoniza de maneira diferente. Para ser justo, a complexidade por trás desses mostradores ainda é bastante vasta.

Ignore a sobreposição lexical e você perde parte desses 40% dos votos. Escreva um conteúdo semanticamente fino e você pode perder mais 40. Derrugar ou enterrar sua resposta, e você não ganhará novamente. Almofada com cotão e você sente falta do aumento da clareza.

A luta pela faca não acontece mais em um serp. Isso acontece dentro do pipeline de seleção de respostas. E é altamente improvável que esses mostradores sejam estáticos. Você pode apostar que eles se movem em relação a muitos outros fatores, incluindo o posicionamento relativo um do outro.

A próxima camada: verificação

Hoje, a seleção de respostas é o último portão antes da geração. Mas o próximo estágio já está em vista: verificação.

Pesquisas mostram como os modelos podem se criticar e aumentar a factualidade. Auto-RAG Demonstra alças de recuperação, geração e crítica. Selfcheckgpt Executa verificações de consistência em várias gerações. Openai é relatado estar construindo um verificador universal para o GPT-5. E eu escrevi sobre todo esse tópico em um recente Artigo de Substack.

Quando as camadas de verificação amadurecem, a recuperação só o levará à sala. A verificação decidirá se você ficar lá.

Fechamento

Isso realmente não é um SEO regular disfarçado. É uma mudança. Agora podemos ver mais claramente as engrenagens girando porque mais da pesquisa é pública. Também vemos a volatilidade porque cada plataforma gira essas engrenagens de maneira diferente.

Para os SEOs, acho que o argumento é claro. Mantenha a sobreposição lexical forte. Construa densidade semântica em aglomerados. Lidere com a resposta. Torne as passagens concisas e eleváveis. E eu entendo o quanto isso soa como orientação tradicional de SEO. Também entendo como as plataformas que usam as informações diferem muito dos mecanismos de pesquisa regulares. Essas diferenças são importantes.

É assim que você sobrevive à luta pela faca dentro da IA. E logo, como você passa no teste do verificador quando estiver lá.

Mais recursos:

Este post foi publicado originalmente em Duane Forrester decodifica.

Imagem em destaque: tete_escape/shutterstock

#Vamos #olhar #para #dentro #mecanismo #resposta #ver #como #Genai #escolhe #vencedores